An der Schwelle einer neuen Ära

Wir stehen an der Schwelle einer neuen Ära, in der Roboter und autonome Systeme zunehmend Teil unseres täglichen Lebens werden. Von Industrierobotern, die unsere Fabriken verändern, über Pflegeroboter, die in Krankenhäusern und Pflegeheimen eingesetzt werden, bis hin zu autonomen Fahrzeugen auf unseren Straßen – die Robotertechnologie dringt in praktisch jeden Bereich unserer Gesellschaft vor.

Diese rasante Entwicklung bringt nicht nur technologische Herausforderungen mit sich, sondern wirft auch grundlegende ethische, soziale und regulatorische Fragen auf. Wie sollen Roboter programmiert werden, um ethische Entscheidungen zu treffen? Wer trägt die Verantwortung, wenn autonome Systeme Schaden anrichten? Wie können wir sicherstellen, dass diese Technologien die Menschheit voranbringen, anstatt bestehende Ungleichheiten zu verschärfen?

"Die Frage ist nicht, ob Roboter ethische Entscheidungen treffen werden, sondern wie. Und die Antwort darauf wird nicht von den Robotern selbst kommen, sondern von uns – wie wir sie entwerfen, programmieren und regulieren."

Prof. Dr. Christoph Lütge, Direktor des Instituts für Ethik in der KI, TU München

Grundlegende ethische Herausforderungen in der Robotik

Die ethischen Fragen, die durch die Entwicklung und den Einsatz von Robotern aufgeworfen werden, sind vielfältig und komplex. Sie berühren fundamentale philosophische Konzepte wie Autonomie, Verantwortung, Gerechtigkeit und menschliche Würde.

Autonomie und Entscheidungsfindung

Mit zunehmender Autonomie von Robotersystemen stellt sich die Frage, wie viel Entscheidungsfreiheit diesen Systemen überlassen werden sollte:

- Das Dilemma der Delegierung: Welche Entscheidungen sollten Menschen treffen und welche können an Maschinen delegiert werden?

- Vorhersehbarkeit vs. Autonomie: Je autonomer ein System ist, desto weniger vorhersehbar wird sein Verhalten, was ethische und rechtliche Fragen aufwirft.

- Moralische Algorithmen: Können und sollten wir versuchen, moralische Grundsätze in Algorithmen zu kodieren?

Ein anschauliches Beispiel für diese Herausforderung ist das bekannte "Trolley-Problem" in Bezug auf autonome Fahrzeuge: Wie sollte ein selbstfahrendes Auto programmiert werden, wenn es in eine unvermeidbare Unfallsituation gerät, bei der verschiedene Handlungsoptionen unterschiedliche Opfer fordern könnten?

Verantwortung und Haftung

Mit zunehmender Autonomie von Robotern wird die Zuordnung von Verantwortung komplexer:

- Verantwortungslücke: Wer trägt die Verantwortung, wenn ein autonomes System einen Schaden verursacht – der Hersteller, der Programmierer, der Benutzer oder das System selbst?

- Transparenz und Nachvollziehbarkeit: Wie können wir sicherstellen, dass die Entscheidungsprozesse autonomer Systeme transparent und nachvollziehbar sind?

- Versicherung und Entschädigung: Welche Mechanismen sind notwendig, um Opfer von Fehlern oder Unfällen mit autonomen Systemen angemessen zu entschädigen?

Privatsphäre und Datenschutz

Roboter und autonome Systeme sammeln und verarbeiten große Mengen an Daten, oft in sensiblen Umgebungen:

- Überwachungspotenzial: Wie verhindern wir, dass Roboter zu Überwachungsinstrumenten werden, die die Privatsphäre gefährden?

- Sensitive Daten: Besondere Bedenken entstehen, wenn Roboter in intimen Umgebungen wie Pflegeeinrichtungen oder Privathaushalten eingesetzt werden.

- Datensouveränität: Wer kontrolliert die von Robotern gesammelten Daten und zu welchem Zweck dürfen sie verwendet werden?

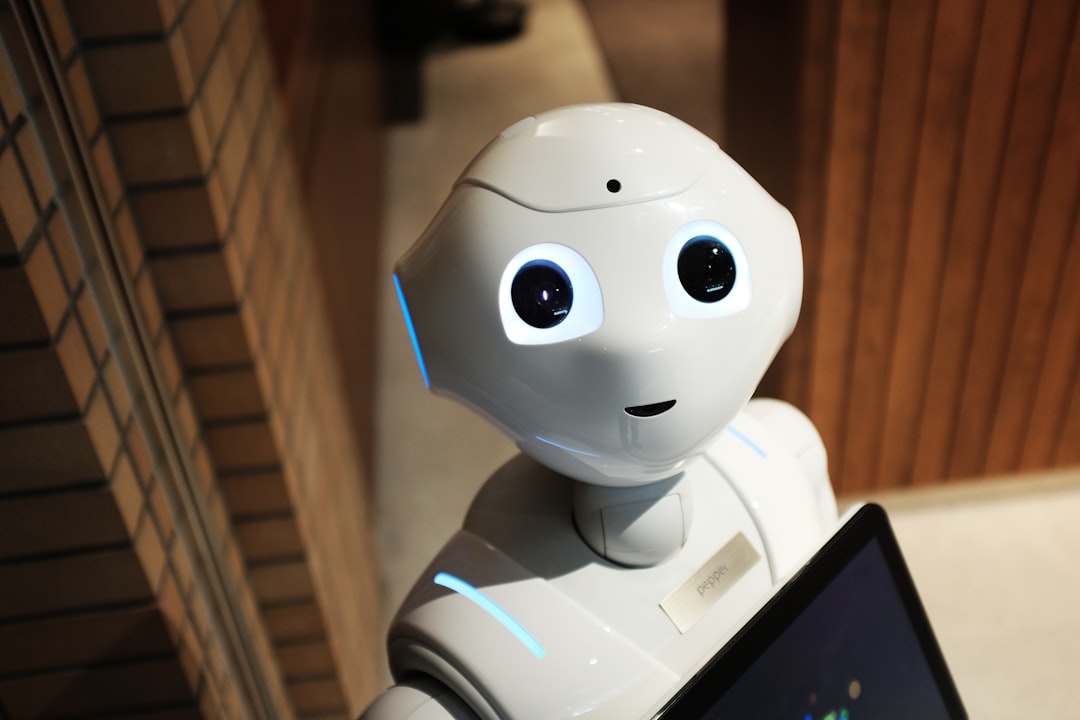

Roboter im Gesundheitswesen sammeln sensible Daten, was besondere Anforderungen an den Datenschutz stellt.

Menschenwürde und soziale Interaktion

Mit der zunehmenden Integration von Robotern in soziale Kontexte entstehen Fragen zur Auswirkung auf menschliche Beziehungen und Würde:

- Entwürdigung durch Automatisierung: Könnte die Pflege durch Roboter die menschliche Würde beeinträchtigen, besonders bei vulnerablen Gruppen wie älteren Menschen?

- Authentizität sozialer Interaktionen: Welche ethischen Implikationen hat es, wenn Menschen emotionale Bindungen zu Maschinen entwickeln?

- Soziale Isolation: Könnten Roboter als Ersatz für menschliche Interaktion dienen und dadurch zur sozialen Isolation beitragen?

Wirtschaftliche Auswirkungen und soziale Gerechtigkeit

Die Robotisierung und Automatisierung haben weitreichende wirtschaftliche und soziale Folgen:

- Arbeitsmarktverschiebungen: Wie gehen wir mit der Verdrängung von Arbeitsplätzen durch Roboter und KI um?

- Verteilung der Vorteile: Wie stellen wir sicher, dass die Vorteile der Robotisierung breit verteilt werden und nicht nur einigen wenigen zugutekommen?

- Zugang zu Technologie: Wie vermeiden wir neue digitale Kluften zwischen denen, die Zugang zu fortschrittlicher Robotertechnologie haben, und denen, die davon ausgeschlossen sind?

Ethische Leitlinien und Grundsätze

Um diesen Herausforderungen zu begegnen, haben verschiedene Organisationen, Forschungseinrichtungen und politische Gremien ethische Leitlinien und Grundsätze für die Robotik und KI entwickelt. Diese dienen als Orientierungsrahmen für Entwickler, Hersteller, Nutzer und Regulierungsbehörden.

Asimovs Robotergesetze und ihre modernen Interpretationen

Die vielleicht bekanntesten ethischen Grundsätze für Roboter sind die drei Gesetze, die der Science-Fiction-Autor Isaac Asimov in den 1940er Jahren formulierte:

- Ein Roboter darf keinem Menschen schaden oder durch Untätigkeit zulassen, dass einem Menschen Schaden zugefügt wird.

- Ein Roboter muss den Befehlen eines Menschen gehorchen – es sei denn, diese Befehle stehen im Widerspruch zum ersten Gesetz.

- Ein Roboter muss seine eigene Existenz schützen – es sei denn, dieser Schutz steht im Widerspruch zum ersten oder zweiten Gesetz.

Während diese Gesetze in der Science-Fiction entstanden, haben sie die Diskussion über Roboterethik maßgeblich beeinflusst. Moderne Interpretationen und Erweiterungen dieser Grundsätze umfassen Aspekte wie Transparenz, Datenschutz und soziale Auswirkungen.

Aktuelle ethische Rahmenwerke

Verschiedene Organisationen haben umfassendere ethische Rahmenwerke für Robotik und KI entwickelt:

- IEEE Global Initiative on Ethics of Autonomous and Intelligent Systems: Entwickelt ethische Standards für die Entwicklung und Implementierung autonomer und intelligenter Systeme.

- EU-Leitlinien für vertrauenswürdige KI: Betonen Aspekte wie menschliche Autonomie, Fairness, Transparenz und Rechenschaftspflicht.

- OECD-Prinzipien für KI: Fokussieren auf menschenzentrierte Werte, Transparenz, Robustheit und Rechenschaftspflicht.

- Asilomar-Prinzipien für KI: Eine Reihe von 23 Grundsätzen für die sichere und nutzbringende Entwicklung von KI, die von führenden KI-Forschern entwickelt wurden.

Diese Rahmenwerke betonen einige gemeinsame Grundprinzipien:

- Menschliches Wohlbefinden: Roboter und KI sollten zum Wohle der Menschheit entwickelt und eingesetzt werden.

- Autonomie und Kontrolle: Menschen sollten die Kontrolle über Technologie behalten, und menschliche Autonomie sollte respektiert werden.

- Fairness und Nichtdiskriminierung: Systeme sollten fair und ohne Diskriminierung funktionieren.

- Transparenz und Erklärbarkeit: Die Funktionsweise von Robotern und KI sollte transparent und erklärbar sein.

- Sicherheit und Robustheit: Systeme sollten sicher, zuverlässig und robust gegen Missbrauch sein.

- Privatsphäre und Datenschutz: Die Privatsphäre und persönliche Daten sollten geschützt werden.

- Verantwortlichkeit: Es sollten klare Mechanismen für die Zuschreibung von Verantwortung geben.

Diskussion über ethische Grundsätze in der Robotik bei einem internationalen Workshop.

Regulatorische Ansätze und Herausforderungen

Neben ethischen Leitlinien ist eine angemessene Regulierung erforderlich, um sicherzustellen, dass Roboter sicher, verantwortungsvoll und im Einklang mit gesellschaftlichen Werten entwickelt und eingesetzt werden. Die Regulierung von Robotik steht jedoch vor einzigartigen Herausforderungen.

Aktuelle regulatorische Landschaft

Die Regulierung von Robotik ist derzeit fragmentiert und entwickelt sich in verschiedenen Regionen unterschiedlich:

- Europäische Union: Die EU verfolgt einen proaktiven Ansatz mit dem Vorschlag für eine KI-Verordnung, die risikobasierte Kategorien für KI-Systeme definiert und unterschiedliche Anforderungen stellt. Zudem gibt es spezifische Richtlinien für Produktsicherheit und Haftung, die auch für Roboter gelten.

- USA: Die USA verfolgen einen eher sektorspezifischen Ansatz, wobei verschiedene Behörden wie die FDA (für medizinische Roboter) oder die NHTSA (für autonome Fahrzeuge) eigene Regulierungsrahmen entwickeln.

- Asien: Länder wie Japan, Südkorea und China entwickeln nationale Strategien und Regulierungsrahmen für Robotik, oft mit spezifischen Schwerpunkten auf industrieller Robotik oder Servicerobotik.

Herausforderungen bei der Regulierung

Die Regulierung von Robotik und KI steht vor mehreren einzigartigen Herausforderungen:

- Schnelle technologische Entwicklung: Regulierungen können schnell veralten angesichts des rasanten technologischen Fortschritts.

- Komplexität und Undurchsichtigkeit: Die Komplexität moderner KI-Systeme macht es schwierig, ihr Verhalten vorherzusagen und zu regulieren.

- Globale Dimension: Robotik ist ein globales Phänomen, das internationale Koordination erfordert, um Regulierungsarbitrage zu vermeiden.

- Abwägung zwischen Innovation und Sicherheit: Zu strenge Regulierungen könnten Innovation hemmen, während zu laxe Ansätze Risiken bergen.

- Verschiedene Anwendungsbereiche: Unterschiedliche Anwendungen (z.B. Industrieroboter vs. Pflegeroboter) erfordern unterschiedliche regulatorische Ansätze.

Innovative Regulierungsansätze

Um diesen Herausforderungen zu begegnen, werden verschiedene innovative Regulierungsansätze diskutiert und erprobt:

- Risikobasierte Regulierung: Abstufung der regulatorischen Anforderungen basierend auf dem Risikopotenzial des Systems.

- Regulatorische Sandboxen: Kontrollierte Umgebungen, in denen neue Technologien getestet werden können, ohne sofort allen regulatorischen Anforderungen unterworfen zu sein.

- Prinzipienbasierte Regulierung: Fokussierung auf übergeordnete Prinzipien statt detaillierter Vorschriften, um Flexibilität zu gewährleisten.

- Selbstregulierung und Zertifizierung: Brancheninitiativen und Standardisierungsorganisationen entwickeln technische Standards und Zertifizierungsprogramme.

- Algorithmische Aufsicht: Spezifische Mechanismen zur Überprüfung und Kontrolle algorithmischer Entscheidungssysteme.

Spezifische Regulierungsbereiche

Einige Bereiche erfordern besondere regulatorische Aufmerksamkeit:

- Sicherheitsstandards: Gewährleistung der physischen Sicherheit von Mensch-Roboter-Interaktionen (z.B. ISO/TS 15066 für kollaborative Roboter).

- Haftung und Versicherung: Klärung von Haftungsfragen bei Unfällen oder Schäden durch autonome Systeme, möglicherweise durch neue Haftungsmodelle oder Pflichtversicherungen.

- Datenschutz und Cybersicherheit: Schutz der von Robotern gesammelten Daten und Absicherung gegen Hacking oder Manipulation.

- Zulassung und Zertifizierung: Entwicklung von Verfahren zur Prüfung und Zulassung autonomer Systeme vor dem Marktzugang.

- Ethische Überprüfung: Integration ethischer Bewertungen in Zulassungsverfahren, besonders für hochrisiko Anwendungen.

Ethik in der Praxis: Implementierung ethischer Grundsätze

Die Überführung ethischer Grundsätze in die praktische Entwicklung und den Einsatz von Robotern ist eine komplexe Aufgabe, die verschiedene methodische Ansätze erfordert.

Ethics by Design

"Ethics by Design" ist ein Ansatz, der ethische Überlegungen von Beginn an in den Entwicklungsprozess integriert:

- Ethische Anforderungsanalyse: Identifikation relevanter ethischer Aspekte bereits in der Anforderungsphase.

- Wertesensitive Gestaltung: Berücksichtigung menschlicher Werte wie Privatsphäre, Autonomie und Fairness im Designprozess.

- Partizipatives Design: Einbeziehung verschiedener Stakeholder, einschließlich potenzieller Nutzer und betroffener Gruppen.

- Ethische Risikoanalyse: Systematische Identifikation und Bewertung potenzieller ethischer Risiken und Dilemmata.

Technische Methoden zur Umsetzung ethischer Grundsätze

Verschiedene technische Ansätze werden entwickelt, um ethische Grundsätze in Robotersysteme zu integrieren:

- Erklärbare KI (XAI): Entwicklung von Methoden, die die Entscheidungen autonomer Systeme transparent und nachvollziehbar machen.

- Formale Verifikation: Mathematische Methoden zur Überprüfung, ob ein System bestimmten Spezifikationen entspricht, einschließlich ethischer Constraints.

- Ethische Guardrails: Implementierung von Sicherheitsmechanismen, die verhindern, dass Systeme ethische Grenzen überschreiten.

- Fairness-Metriken und -Tools: Werkzeuge zur Messung und Verbesserung der Fairness von algorithmischen Entscheidungssystemen.

- Privacy-Enhancing Technologies (PETs): Technologien zum Schutz der Privatsphäre bei der Datenerhebung und -verarbeitung.

Ein interdisziplinäres Team arbeitet an der Integration ethischer Prinzipien in den Designprozess eines Pflegeroboters.

Organisatorische Maßnahmen

Neben technischen Ansätzen sind organisatorische Maßnahmen entscheidend für die ethische Gestaltung und den Einsatz von Robotern:

- Ethikkommissionen und -räte: Einrichtung von interdisziplinären Gremien zur Bewertung ethischer Aspekte von Robotikprojekten.

- Ethische Folgenabschätzung: Systematische Bewertung der ethischen, sozialen und rechtlichen Auswirkungen neuer Robotertechnologien.

- Ethik-Kodizes und Richtlinien: Entwicklung und Implementierung spezifischer Ethik-Kodizes für Robotik-Entwickler und -Anwender.

- Ausbildung und Bewusstseinsbildung: Integration ethischer Themen in die Ausbildung von Ingenieuren, Programmierern und anderen Fachleuten.

- Stakeholder-Engagement: Kontinuierlicher Dialog mit verschiedenen gesellschaftlichen Gruppen über die ethischen Implikationen von Robotertechnologien.

Branchenspezifische Herausforderungen

Verschiedene Anwendungsbereiche von Robotern stellen unterschiedliche ethische Anforderungen:

- Gesundheits- und Pflegeroboter: Besondere Betonung auf Würde, Autonomie und informierte Einwilligung vulnerabler Patienten.

- Militärische Roboter: Komplexe Fragen bezüglich tödlicher autonomer Waffensysteme und der menschlichen Kontrolle über Gewaltanwendung.

- Bildungsroboter: Bedenken hinsichtlich der Entwicklung von Kindern und der Qualität pädagogischer Interaktionen.

- Industrieroboter: Fokus auf Arbeitssicherheit, Arbeitsplatzqualität und sozioökonomische Auswirkungen.

- Soziale Roboter: Fragen bezüglich emotionaler Manipulation, psychologischer Auswirkungen und sozialer Isolation.

Globale Perspektiven und kulturelle Unterschiede

Die ethischen und regulatorischen Ansätze für Robotik werden auch von kulturellen, philosophischen und rechtlichen Traditionen beeinflusst, die sich weltweit unterscheiden.

Kulturelle Unterschiede in der Roboterethik

Verschiedene Kulturkreise haben unterschiedliche Perspektiven auf Roboter und ihre Rolle in der Gesellschaft:

- Westliche Perspektive: Tendiert dazu, die Mensch-Maschine-Grenze zu betonen und Bedenken hinsichtlich der Ersetzung menschlicher Interaktion zu äußern.

- Japanische Perspektive: Geprägt von Shintoismus und animistischen Traditionen, die auch nicht-menschlichen Entitäten eine Art "Seele" zuschreiben, was zu einer größeren Offenheit gegenüber Robotern in sozialen Rollen führt.

- Chinesische Perspektive: Beeinflusst von konfuzianischen Werten mit Betonung auf soziale Harmonie und kollektives Wohlbefinden bei der Bewertung von Robotertechnologien.

- Islamische Perspektive: Diskussion über die Vereinbarkeit von KI und Robotik mit religiösen Prinzipien und der göttlichen Schöpfung.

Diese unterschiedlichen kulturellen Perspektiven beeinflussen, wie Gesellschaften die Entwicklung und den Einsatz von Robotern regulieren und welche ethischen Aspekte besonders betont werden.

Internationale Kooperation und Harmonisierung

Angesichts der globalen Natur der Robotikentwicklung ist internationale Zusammenarbeit erforderlich:

- Globale Governance-Strukturen: Entwicklung internationaler Rahmenwerke für die Governance von Robotik und KI, wie die Arbeit der UNESCO zu KI-Ethik.

- Internationale Standardisierung: Organisationen wie ISO und IEEE arbeiten an globalen technischen Standards für Robotik.

- Multilaterale Initiativen: Kooperationsforen wie der Global Partnership on AI (GPAI) fördern den internationalen Dialog und Wissensaustausch.

- Konvergenz vs. Divergenz: Balance zwischen globaler Harmonisierung und Respekt für kulturelle und regionale Unterschiede.

Zukunftsperspektiven: Aufkommende Herausforderungen

Die ethischen und regulatorischen Herausforderungen in der Robotik werden sich mit der weiteren technologischen Entwicklung verändern und neue Dimensionen annehmen.

Aufkommende technologische Entwicklungen

Mehrere technologische Trends werden neue ethische Fragen aufwerfen:

- Zunehmende Autonomie: Mit fortschreitender KI werden Roboter immer autonomer, was die Frage der menschlichen Kontrolle und Verantwortung weiter kompliziert.

- Affektive Robotik: Roboter, die Emotionen erkennen und simulieren können, werfen Fragen bezüglich emotionaler Manipulation und authentischer Interaktion auf.

- Neuromorphe Systeme: Gehirnähnliche Computersysteme könnten die Grenze zwischen Maschine und menschlichem Denken weiter verwischen.

- Mensch-Maschine-Integration: Die zunehmende Verschmelzung von Mensch und Maschine durch Exoskelette, Implantate und Brain-Computer-Interfaces wirft Fragen zur menschlichen Identität auf.

- Quantencomputing: Könnte die Fähigkeiten von KI und Robotern exponentiell steigern und neue ethische Herausforderungen schaffen.

Weiterentwicklung ethischer und regulatorischer Rahmenwerke

Um mit diesen Entwicklungen Schritt zu halten, müssen ethische und regulatorische Rahmenwerke sich weiterentwickeln:

- Adaptive Regulierung: Flexiblere regulatorische Ansätze, die sich an technologische Entwicklungen anpassen können.

- Antizipatorische Governance: Proaktive Identifikation und Adressierung potenzieller ethischer Herausforderungen, bevor Technologien weit verbreitet sind.

- Globale Ethikstandards: Verstärkte Bemühungen um globale Mindeststandards für ethische KI und Robotik.

- Interdisziplinäre Zusammenarbeit: Engere Kooperation zwischen Technikern, Ethikern, Sozialwissenschaftlern und politischen Entscheidungsträgern.

- Kontinuierliche öffentliche Beteiligung: Breitere gesellschaftliche Diskussion über die gewünschte Rolle von Robotern in der Gesellschaft.

Die Zukunft der Roboterethik erfordert eine enge Zusammenarbeit zwischen verschiedenen Disziplinen und Stakeholdern.

Fazit: Der Weg zu einer verantwortungsvollen Robotik

Die Entwicklung und der Einsatz von Robotern stehen an einem entscheidenden Punkt. Die Technologie schreitet rasch voran und eröffnet beispiellose Möglichkeiten, das menschliche Leben zu verbessern – von der Steigerung der Produktivität und der Unterstützung älterer Menschen bis hin zur Bewältigung globaler Herausforderungen wie dem Klimawandel.

Gleichzeitig bringt diese Entwicklung tiefgreifende ethische und gesellschaftliche Fragen mit sich, die sorgfältige Überlegung und proaktives Handeln erfordern. Die Art und Weise, wie wir diese Fragen angehen, wird entscheidend dafür sein, ob Robotertechnologie zu einer gerechteren, sichereren und lebenswerten Zukunft beiträgt oder bestehende Probleme verschärft.

Der Weg zu einer verantwortungsvollen Robotik erfordert einen mehrdimensionalen Ansatz:

- Ethik als integraler Bestandteil: Ethische Überlegungen müssen von Anfang an in den Entwicklungsprozess integriert werden, nicht als nachträgliche Überlegung.

- Ausgewogene Regulierung: Regulatorische Rahmenwerke müssen Innovation ermöglichen, während sie gleichzeitig Sicherheit, Gerechtigkeit und menschliche Werte schützen.

- Breite Beteiligung: Die Gestaltung der Roboterzukunft sollte nicht nur Experten überlassen werden, sondern eine breite gesellschaftliche Beteiligung einschließen.

- Kontinuierliches Lernen: Angesichts der schnellen technologischen Entwicklung ist ein kontinuierlicher Lern- und Anpassungsprozess erforderlich.

- Globale Zusammenarbeit: Die globale Natur der Robotikentwicklung erfordert internationale Kooperation und Dialog.

Letztendlich geht es nicht darum, ob Roboter eine größere Rolle in unserem Leben spielen werden – diese Entwicklung ist bereits im Gange. Die entscheidende Frage ist vielmehr, wie wir diese Technologien gestalten und steuern, um sicherzustellen, dass sie im Einklang mit unseren tiefsten menschlichen Werten und Bestrebungen stehen.

Durch die Kombination ethischer Reflexion, umsichtiger Regulierung, technischer Innovation und gesellschaftlicher Beteiligung können wir eine Zukunft gestalten, in der Roboter als Werkzeuge dienen, die das menschliche Potenzial erweitern, anstatt es zu ersetzen oder zu untergraben. Dies erfordert kontinuierliche Aufmerksamkeit und Engagement von allen Beteiligten – von Entwicklern und Unternehmen bis hin zu Regulierungsbehörden und der breiteren Gesellschaft.

Die Reise hat gerade erst begonnen, und die Entscheidungen, die wir heute treffen, werden die Beziehung zwischen Mensch und Maschine für kommende Generationen prägen.